Generative Machine-Learning-Systeme benötigen viel Energie

BiblioMap

BiblioMap

Bemerkungen

Bemerkungen

Es gibt Schätzungen, dass 90

Prozent des Energiebedarfs großer

Sprachmodelle aufs Inferencing entfallen,

nur 10 Prozent aufs Training.

Von Christof Windeck im Text Mücke oder Elefant? (2023) Pretraining LLMs requires access to significant resources and is very

expensive. For example, the GPT-3 pretraining cost is estimated to be $4.6 million in

terms of cloud computing credits (https://mng.bz/VxEW).

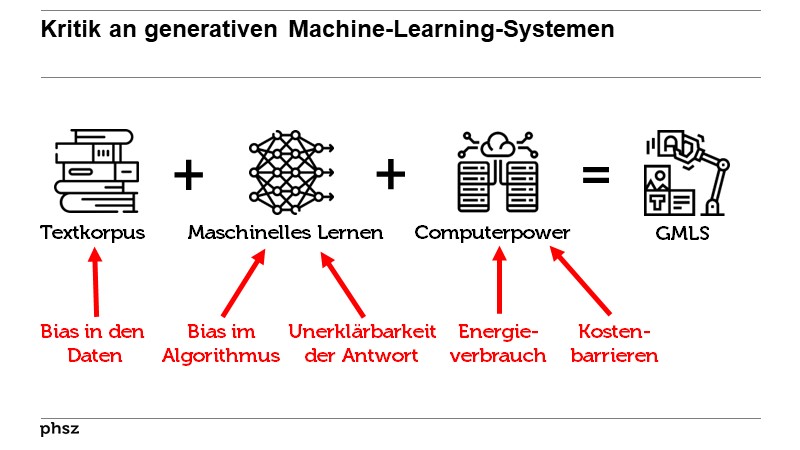

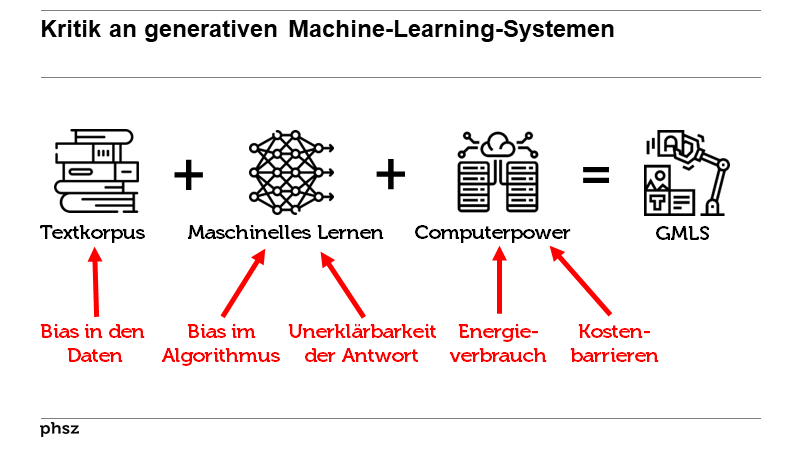

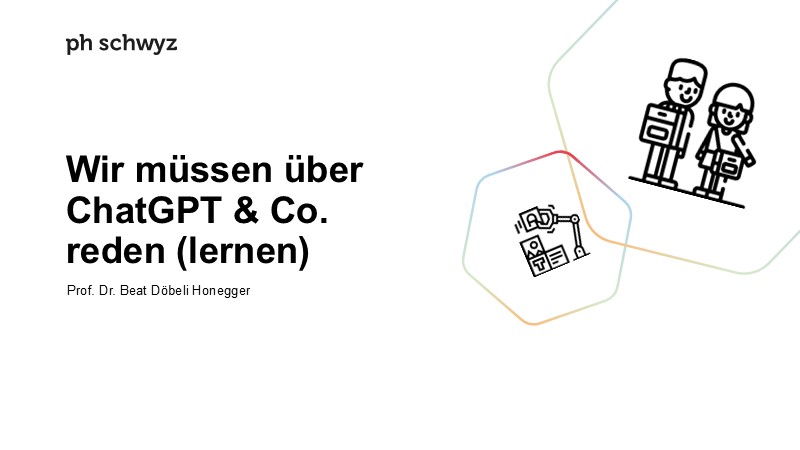

Von Rishi Bommasani, Kevin Klyman, Shayne Longpre, Sayash Kapoor, Nestor Maslej, Betty Xiong, Daniel Zhang, Percy Liang im Text The Foundation Model Transparency Index (2023)  Insbesondere das erstmalige Training von KI-Sprachgeneratoren ist sehr rechen- und damit energieintensiv. Derzeit wird aber intensiv nach sparsameren Trainingsverfahren geforscht, so dass dieser Aspekt mittelfristig an Bedeutung verlieren könnte.

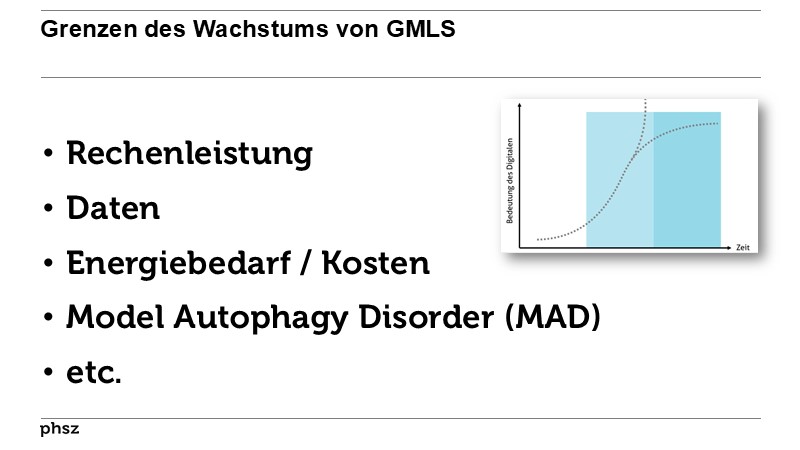

Insbesondere das erstmalige Training von KI-Sprachgeneratoren ist sehr rechen- und damit energieintensiv. Derzeit wird aber intensiv nach sparsameren Trainingsverfahren geforscht, so dass dieser Aspekt mittelfristig an Bedeutung verlieren könnte. Es ist nicht einfach, den exakten Stromverbrauch von KISystemen

zu berechnen, doch eines steht fest: Er steigt kontinuierlich

an. Die besten Modelle werden immer größer, trainieren

mit immer umfangreicheren Datenmengen, und zugleich

nutzen immer mehr Menschen immer mehr KI-Anwendungen.

Es ist nicht einfach, den exakten Stromverbrauch von KISystemen

zu berechnen, doch eines steht fest: Er steigt kontinuierlich

an. Die besten Modelle werden immer größer, trainieren

mit immer umfangreicheren Datenmengen, und zugleich

nutzen immer mehr Menschen immer mehr KI-Anwendungen.Tasks involving images are more energy- and carbon-intensive

compared to those involving text alone. More specifically, tasks involving

predicting categories (text-to-category, image-to-category)

are less energy-intensive than those involving generating images

(e.g. text-to-image), with those involving text between the two

Von Sasha Luccioni, Yacine Jernite, Emma Strubell im Text Power Hungry Processing  Supercomputer sind Energiefresser.

Ein KI-Modell wie GPT-3 einmalig

zu trainieren, verbraucht so viel wie

126 Häuser in Dänemark in einem

Jahr oder ein Auto auf 700000 Kilometer.

Das haben Forscher der Universität

Kopenhagen errechnet. Und

weil ein einziger Trainingsdurchgang

nicht reicht, muss die Zahl noch multipliziert

werden.

Supercomputer sind Energiefresser.

Ein KI-Modell wie GPT-3 einmalig

zu trainieren, verbraucht so viel wie

126 Häuser in Dänemark in einem

Jahr oder ein Auto auf 700000 Kilometer.

Das haben Forscher der Universität

Kopenhagen errechnet. Und

weil ein einziger Trainingsdurchgang

nicht reicht, muss die Zahl noch multipliziert

werden. Der Alltagsbetrieb in der Cloud

verschlingt ebenfalls viel Strom.

»Spätestens jetzt, wo mit Programmen

wie ChatGPT die Schulhausaufgaben

erledigt werden können,

ist KI im Alltag der Menschen angekommen,

und der Energiebedarf

steigt exponentiell«, sagt Christian

Eichhorn, Mitgründer und Co-Geschäftsführer

der Firma SpiNNcloud Systems, einer Ausgründung der Technischen Universität Dresden.

Der Alltagsbetrieb in der Cloud

verschlingt ebenfalls viel Strom.

»Spätestens jetzt, wo mit Programmen

wie ChatGPT die Schulhausaufgaben

erledigt werden können,

ist KI im Alltag der Menschen angekommen,

und der Energiebedarf

steigt exponentiell«, sagt Christian

Eichhorn, Mitgründer und Co-Geschäftsführer

der Firma SpiNNcloud Systems, einer Ausgründung der Technischen Universität Dresden.Momentan befinden wir uns in einer wilden Experimentierphase. Den dafür in Kauf genommen Aufwand kann man nicht einfach in die Zukunft extrapolieren. Denn generative KI wird sich nur dann weit verbreiten, wenn es Geschäftsmodelle gibt, die die Kosten für Energie und Hardware tragen. Zurzeit treten die Firmen dafür meist noch in Vorleistung, um den Aufsprung nicht zu verpassen.

Im Vergleich zu anderen Energieverbrauchern

wirkt der KI-Bedarf eher bescheiden.

Einerseits könnte man mit den

für einen besonders aufwendigen KI-Trainingslauf

nötigen 434.000 kWh zwar fast

30 Einfamilienhäuser ein Jahr lang heizen,

die dazu je 15.000 kWh Gas, Öl oder Strom

benötigen. Andererseits entsprechen

434.000 kWh etwa 36 Tonnen Kerosin,

die ein Airbus A330-300 für einen einzigen

Mittelstreckenflug von Frankfurt nach

Dubai verbrennt.

Von Christof Windeck im Text Mücke oder Elefant? (2023)  Im Hinblick auf die Nachhaltigkeit erfordern grosse Sprachmodelle wie GPT einen hohen Energie-verbrauch für die Berechnungen beim Training und später zum Beantworten der Suchanfragen der Nutzerinnen und Nutzer. Die aktuelle Forschung versucht zwar, energieeffizientere Materialien und Rechnungsmethoden zu entwickeln. Wenn die für diese Anwendungen eingesetzten Server aber nicht mit nachhaltiger Energie betrieben werden, kann ihr CO2-Fussabdruck enorm sein.

Im Hinblick auf die Nachhaltigkeit erfordern grosse Sprachmodelle wie GPT einen hohen Energie-verbrauch für die Berechnungen beim Training und später zum Beantworten der Suchanfragen der Nutzerinnen und Nutzer. Die aktuelle Forschung versucht zwar, energieeffizientere Materialien und Rechnungsmethoden zu entwickeln. Wenn die für diese Anwendungen eingesetzten Server aber nicht mit nachhaltiger Energie betrieben werden, kann ihr CO2-Fussabdruck enorm sein.AI, and particularly generative AI, is highly energy-intensive and poses a threat to environmental sustainability. Visions of millions of students worldwide using AI regularly to support their studies, while schools deploy AI for pedagogic and administrative purposes, is likely to exact a heavy environmental toll. Given today’s students will have to live with the consequences on ongoing environmental degradation, with many highly conscious of the dangers of climate change, education systems may wish to reduce rather than increase their use of energy-intensive educational technologies.

Von Ben Williamson im Text AI in education is a public problem (2024)  11 Vorträge von Beat mit Bezug

11 Vorträge von Beat mit Bezug

- ChatGPT - der iPhone-Moment für KI?

Klausur PHSZ, Oberägeri, 14.02.2023

- BBZGPT

Berufsbildungszentrum Goldau, 17.08.2023

- Nachrichtenkompetenz – und jetzt auch noch ChatGPT & Co.

Tagung "Nachrichtenkompetenz auf Sekundarstufe II" von ZHAW und SRG public value, 03.11.2023

- Wenn ChatGPT in der Lehrer:innenbildung mitredet

(Video des Referats)

Tag der Lehre der PHZH, 01.02.2024

- Was will uns ChatGPT sagen?

8. Pädagogischer Dialog Liechtenstein, Vaduz, 21.02.2024

- Sprachmaschinen.

Deutschsprachige AG Fremdsprachen der EDK, PHZH, 20.03.2024

- Überfluten uns ChatGPT & Co.?

Tagung des Berufsverbands Schulleitungen Bern

Schwellenmätteli Bern, 24.05.2024

- Generative Machine-Learning-Systeme in der Bildung

VR- und GL-Retraite der Orell Füssli Gruppe

Hasliberg, 12.06.2024

- Wenn das Digitale in der Bildung mitzureden beginnt

Bildungstag Kanton Glarus, 04.09.2024

- Zwischen Experimentierfreude und Überforderung

Kaderanlass, Schulkreis Uto Zürich, 03.06.2025

- Wir müssen über ChatGPT & Co. reden (lernen)

swissdidac Bern, 21.11.2025

2 Erwähnungen auf anderen Websites im Umfeld von Beat Döbeli Honegger

2 Erwähnungen auf anderen Websites im Umfeld von Beat Döbeli Honegger

| Website | Webseite | Datum |

|---|---|---|

| ChatGPT & Co. und die Schule | Literatur | 05.04.2023 |

| ChatGPT & Co. und die Schule | Energieverbrauch von grossen Sprachmodellen | 16.04.2023 |

Zitationsgraph

Zitationsgraph

Zitationsgraph (Beta-Test mit vis.js)

Zitationsgraph (Beta-Test mit vis.js)

Zeitleiste

Zeitleiste

47 Erwähnungen

47 Erwähnungen

- Power Hungry Processing - Watts Driving the Cost of AI Deployment? (Sasha Luccioni, Yacine Jernite, Emma Strubell)

- Künstliche Intelligenz und Wir - Stand, Nutzung und Herausforderungen der KI (Frank Schmiedchen, Alexander von Gernler, Martina Hafner, Klaus Peter Kratzer)

- IT-Infrastrukturen und deren Stromverbrauch (Dieter Kranzlmüller, Andrew Grimshaw)

- IT-Infrastrukturen und deren Stromverbrauch (Dieter Kranzlmüller, Andrew Grimshaw)

- Skalierungshypothese vs. Neurosymbolik - Welche nächsten Schritte muss die KI-Forschung gehen? (Pina Merkert, Philipp Bongartz) (2022)

- ChatGPT-style search represents a 10x cost increase for Google, Microsoft (Ron Amadeo) (2023)

- Die neue Weltmacht - Wie ChatGPT und Co. unser Leben verändern (Titelthema Spiegel 10/2023) (2023)

- Sechs Dinge, die man braucht, um eine KI zu bauen (Patrick Beuth) (2023)

- Sechs Dinge, die man braucht, um eine KI zu bauen (Patrick Beuth) (2023)

- ChatGPT – wenn die künstliche Intelligenz schreibt wie ein Mensch - Und was es dabei zu beachten gilt (TA SWISS Zentrum für Technikfolgen-Abschätzung, Laetitia Ramelet) (2023)

- ChatGPT und andere Computermodelle zur Sprachverarbeitung - Grundlagen, Anwendungspotenziale und mögliche Auswirkungen (Steffen Albrecht) (2023)

- Der ökologische Fußabdruck von KI-Systemen - Die dunkle Seite des Fortschritts (Bernd Müller) (2023)

- From Words to Watts - Benchmarking the Energy Costs of Large Language Model Inference (Siddharth Samsi, Dan Zhao, Joseph McDonald, Baolin Li, Adam Michaleas, Michael Jones, William Bergeron, Jeremy Kepner, Devesh Tiwari, Vijay Gadepally) (2023)

- Künstliche Intelligenz, Large Language Models, ChatGPT und die Arbeitswelt der Zukunft (Michael Seemann) (2023)

- Apokalypse als Businessmodell (Felix Maschewski, Anna-Verena Nosthoff) (2023)

- The growing energy footprint of artificial intelligence (Alex de Vries) (2023)

- The Foundation Model Transparency Index (Rishi Bommasani, Kevin Klyman, Shayne Longpre, Sayash Kapoor, Nestor Maslej, Betty Xiong, Daniel Zhang, Percy Liang) (2023)

- Mücke oder Elefant? - Weshalb sich der KI-Stromverbrauch schlecht einschätzen lässt (Christof Windeck) (2023)

- Making an image with generative AI uses as much energy as charging your phone (Melissa Heikkiläarchive) (2023)

- On the Limits of Artificial Intelligence (AI) in Education (Neil Selwyn) (2024)

- Large Language Models und ihre Potenziale im Bildungssystem - Impulspapier der Ständigen Wissenschaftlichen Kommission der Kultusministerkonferenz (SWK Ständige Wissenschaftliche Kommission der KMK) (2024)

- KI:Text - Diskurse über KI-Textgeneratoren (Gerhard Schreiber, Lukas Ohly) (2024)

- ChatGPT als doppelte Herausforderung für die Wissenschaft - Eine Reflexion aus der Perspektive der Technikfolgenabschätzung (Steffen Albrecht)

- ChatGPT als doppelte Herausforderung für die Wissenschaft - Eine Reflexion aus der Perspektive der Technikfolgenabschätzung (Steffen Albrecht)

- How much electricity does AI consume? (James Vincent) (2024)

- Mehr Intelligenz könnte dem Klima schaden (Thomas Brandstetter) (2024)

- AI in education is a public problem (Ben Williamson) (2024)

- Alles überall auf einmal - Wie Künstliche Intelligenz unsere Welt verändert und was wir dabei gewinnen können (Miriam Meckel, Léa Steinacker) (2024)

- 9. Das ethische Spiegelkabinett - Wenn KI Werte nachahmt

- 9. Das ethische Spiegelkabinett - Wenn KI Werte nachahmt

- The Scariest Part About Artificial Intelligence (Liza Featherstone) (2024)

- Will A.I. Ever Live Up to Its Hype? (Julia Angwin) (2024)

- Microsoft: KI lässt Emissionen um bis zu 40 Prozent steigen (Mark Mantel) (2024)

- Die neuen Stromfresser (Tim Neumann) (2024)

- Künstliche Intelligenz - wie Kinder im digitalen Zeitalter lernen (Beat Döbeli Honegger, Damian Haas) (2024)

- What is 'AI washing' and why is it a problem? (Emma Woollacott) (2024)

- Kann KI grün sein? (Friederike Rohde, Greta Friedrich) (2024)

- Was Menschen die KI wirklich fragen (Anna Weber, Ruth Fulterer) (2024)

- Die Bevölkerung wächst, aber der Stromverbrauch nimmt ab (Simon Thönen) (2025)

- Using ChatGPT is not bad for the environment (Andy Masley) (2025)

- Handbuch Lernen mit digitalen Medien (3. Auflage) - Wege der Transformation (Gerold Brägger, Hans-Günter Rolff) (2025)

- 1. Generative Machine-Learning-Systeme - Die nächste Herausforderung des digitalen Leitmedienwechsels (Beat Döbeli Honegger) (2025)

- 1. Generative Machine-Learning-Systeme - Die nächste Herausforderung des digitalen Leitmedienwechsels (Beat Döbeli Honegger) (2025)

- Does ChatGPT use 10x more energy than a standard Google search? (Marcel Salathé) (2025)

- AI is Destroying the University and Learning Itself (Ronald Purser) (2025)

- Unter Zugzwang - Künstliche Intelligenz (Enrico Kampmann, Judith Kormann) (2025)

- Wissenschaftliches Schreiben mit KI (Isabella Buck) (2025)

- Die KI ist nicht allein schuld - KI und Rechenzentren zweitrangig für global steigenden Strombedarf (Georgiy Belashov, Casey Crownhart) (2025)

- AI Energy Use in Everyday Terms (Marcel Salathé) (2025)

- Maschinen mit Heisshunger (Enrico Kampmann) (2025)

- Saying ‘Thank You’ to ChatGPT Is Costly - But Maybe It’s Worth the Price. (Sopan Deb) (2025)

- Replies to criticisms of my posts on ChatGPT & the environment (Andy Masley) (2025)

- Künstliche Intelligenz frisst immer mehr Strom (2025)

- «Diese Blase wird platzen» (Karen Hao, Ruth Fulterer) (2025)

- Insel der Wasserschlucker (Peter Stäuber) (2025)

- Energieengpässe wegen KI - Boom von KI-Rechenzentren treibt die US-Strompreise (Greta Friedrich) (2025)

- Kompass Künstliche Intelligenz - Ein Reiseführer durch eine Welt in verrückten Zeiten (Marcel Salathé) (2025)

Biblionetz-History

Biblionetz-History